3 innovation points

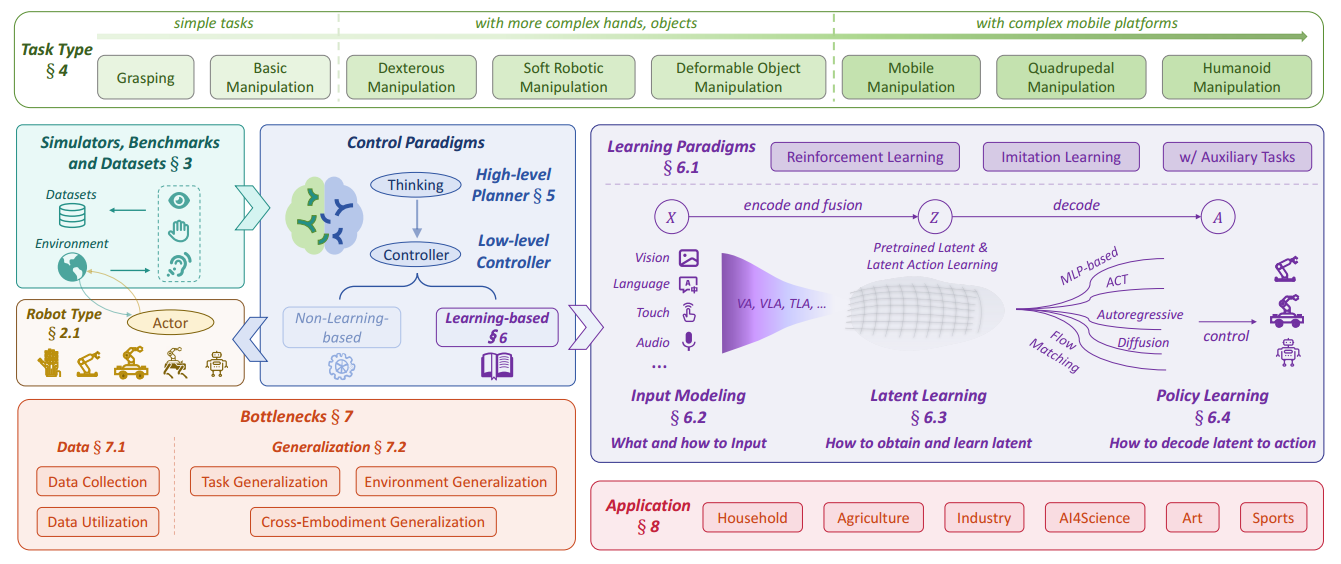

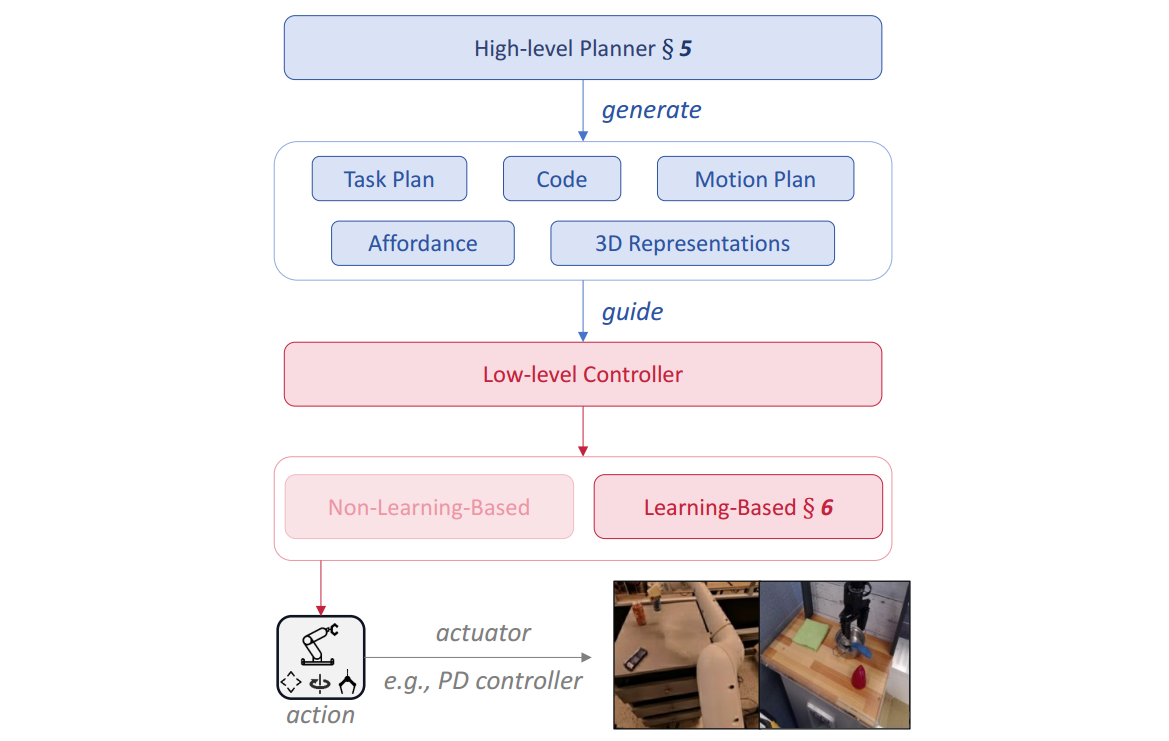

- 统一框架:将传统“规划-控制”二分法扩展为更细粒度、更现代的学习范式,高层规划(What & When)决定“做什么”和“顺序”,低层控制(How)决定“如何做”

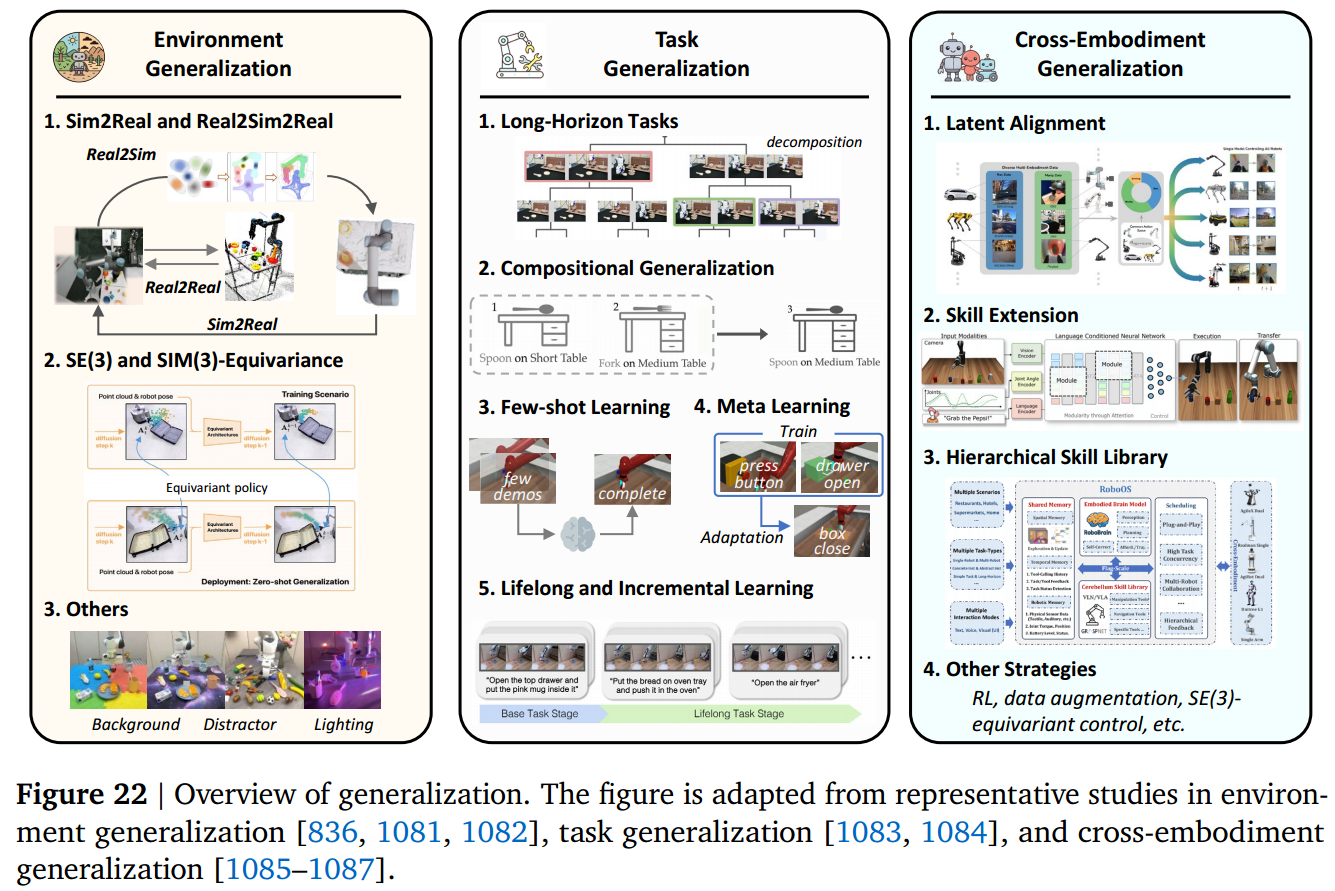

- 核心瓶颈:数据瓶颈涉及收集和利用,包括低成本遥操作、合成生成、数据选择、检索、增强、扩展和重加权;泛化瓶颈包括环境泛化、任务泛化和跨本体泛化

- 未来方向:构建“机器人脑”、突破数据与 Sim2Real 瓶颈、多模态物理交互、安全协作,旨在实现单一通用模型跨 embodiment、跨任务、持续学习且长时程稳健

5 thoughts

- 大多方向都在朝着 VLA 发展,大概因为 VLA 是最有可能实现泛化的;但纯 3D 几何、物理约束、SSM/SNN 等仍在并行推进,未来是“VLM 先验 + 传统控制器”混合大脑,而非单一巨型 VLA

- VLA 的核心问题在于:不稳定、不具有可解释性、长时程累积误差、跨 embodiment 对齐幻觉、高延迟等;需要结合物理约束/结合传统方法,比如“可微仿真+ MPC 包装”

- IL 需要专家数据,难以大规模,未来 crowdsourcing、XR 遥操、自动重标记、生成式伪演示等解决;RL 引入新数据时容易遗忘,需要共享表征+正则+回放

- 后期方向大约是 VLM(先验)+ RL(探索)+IL(纠正)+World Model(模拟+物理约束? 或者外挂 MPC)

- Policy 发展方向:短期,扩散 → 流匹配;长期,3D-VLA 世界模型一体化

Notes

核心内容提炼

Abstract

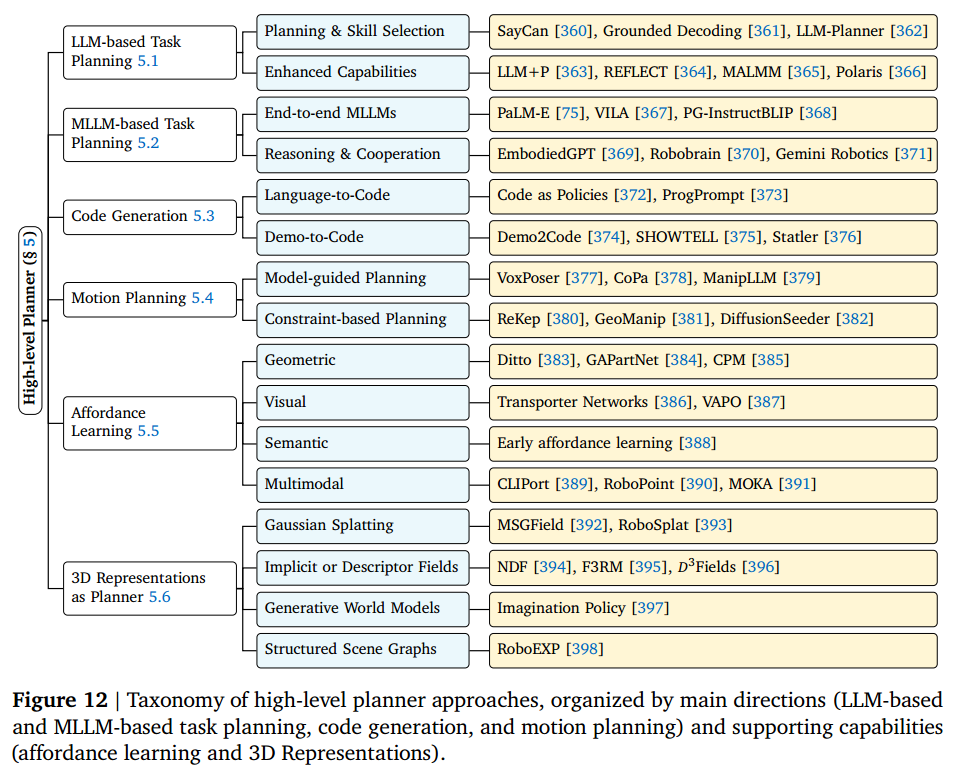

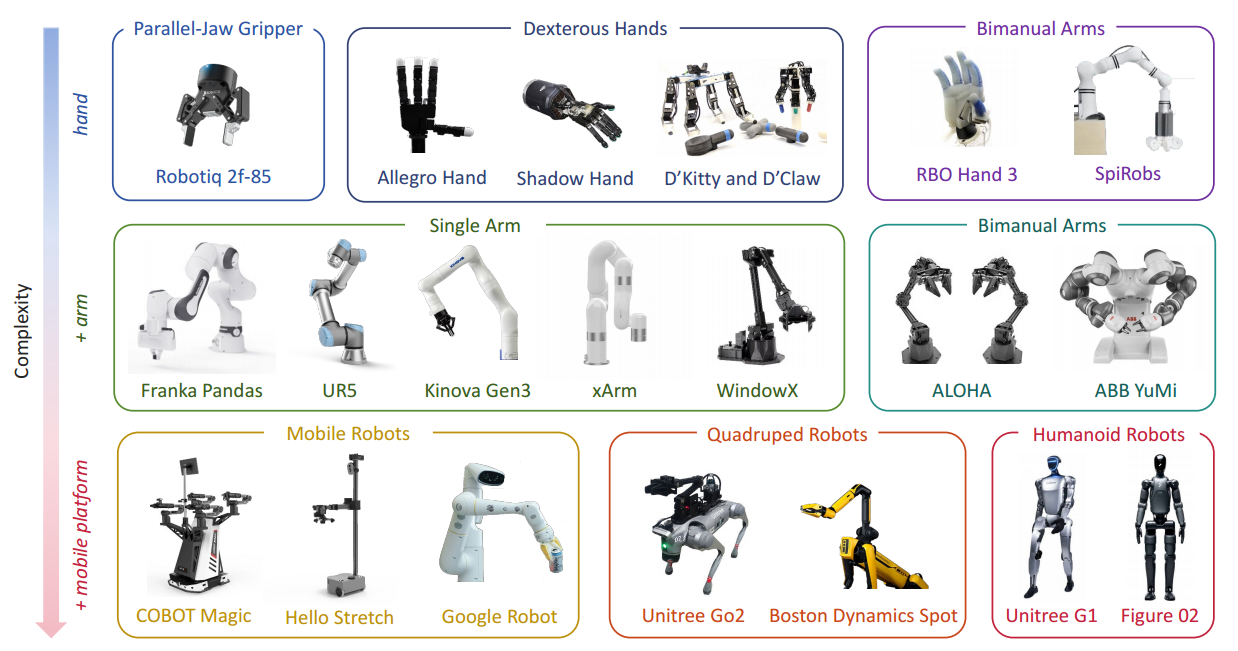

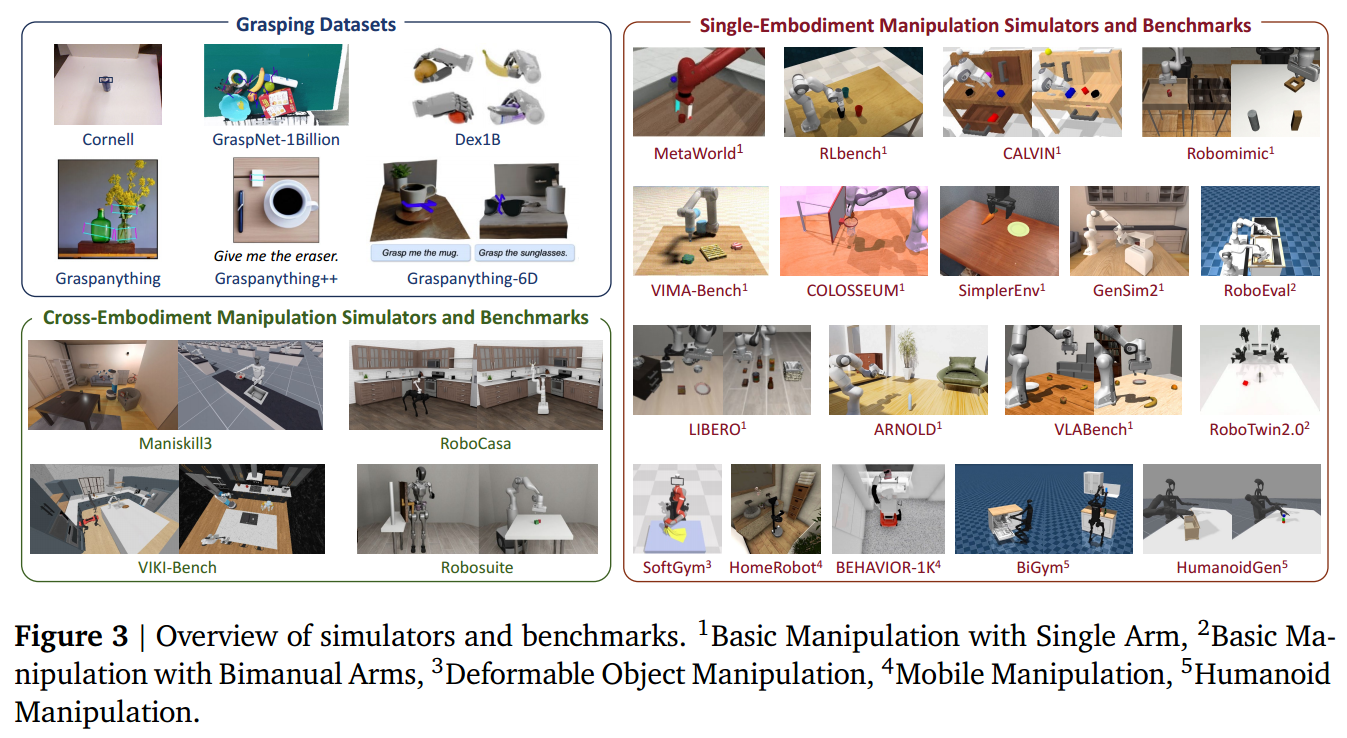

章节 标题 页码 内容概要 1 Introduction p.5 明确综述目标:统一理解机器人操作;对比以往综述(更广+更深);提出四大核心问题(任务/方法/瓶颈/应用) 2 Background p.6 硬件平台(单臂、双臂、灵巧手、移动、四足、人形等);控制范式(非学习 vs 学习);机器人模型(视觉/语言/多模态);评估指标 3 Simulators, Benchmarks and Datasets p.12 按任务类型分类的仿真器、基准和数据集(抓取、单体、跨体、轨迹、具身 QA 等) 4 Manipulation Tasks p.16 八类任务详解:抓取、基础操作、灵巧操作、软体操作、可变形物体、移动操作、四足操作、人形操作 5 High-level Planner p.27 高层规划:LLM/MLLM 任务规划、代码生成、运动规划、可供性(affordance)、3D 表示 6 Low-level Learning-based Control p.33 低层控制:学习策略(RL/IL/混合)、输入建模(视觉/语言/触觉等)、潜在表示学习、策略学习(MLP/Transformer/扩散/流匹配等) 7 Approaches to the Key Bottlenecks p.63 两大瓶颈:数据(收集+利用)与泛化(环境/任务/跨本体) 8 Applications p.75 六大应用场景:家庭、农业、工业、AI4Science、艺术、体育 9 Prospective Future Research Directions p.78 四大挑战:构建“机器人脑”、数据与 Sim2Real 瓶颈、多模态物理交互、安全协作 10 Conclusion p.81 总结全文,强调统一理解的重要性 Appendix A 附录:仿真器/数据集详情 p.173 补充第 3 章的详细列表

统一框架 :高层规划 + 低层控制(图 11, p.27)

Tip

✅ 这是全文最核心的贡献:将传统“规划-控制”二分法扩展为更细粒度、更现代的学习范式。

- 高层规划(What & When):决定“做什么”和“顺序”,包括:

- LLM/MLLM 任务分解(p.28)

- 代码生成(p.30)

- 运动规划(p.30)

- 可供性(affordance)与 3D 表示作为规划器(p.31–32)

- 低层控制(How):决定“如何做”,提出新分类法(p.33):

- 输入建模(视觉/语言/触觉/音频等,p.47)

- 潜在学习(预训练表示 + 潜在动作空间,p.55)

- 策略学习(MLP/Transformer/扩散/流匹配/SSM/SNN 等,p.58)

任务分类体系(图 1, p.2;表 6, p.17)

- 抓取(Grasping):作为独立子任务(p.17)

- 基础操作(Basic Manipulation):pick-and-place 等,研究最充分(p.19)

- 灵巧操作(Dexterous):多指手精细控制(p.19)

- 软体机器人(Soft):柔性执行器(p.21)

- 可变形物体(Deformable):布料、绳子、食物(p.22)

- 移动操作(Mobile):带底盘的机械臂(p.23)

- 四足操作(Quadrupedal):用腿或背载臂操作(p.24)

- 人形操作(Humanoid):全身协调(p.26)

两大核心瓶颈(第 7 章, p.63)

- 数据瓶颈:

- 收集:低成本遥操作(如 ALOHA)、XR、合成生成(如 MimicGen)

- 利用:选择、检索、增强、扩展、重加权(p.68)

- 泛化瓶颈:

- 环境泛化:Sim2Real、SE (3) 等变性(p.70)

- 任务泛化:长时序、组合性、少样本、持续学习(p.72)

- 跨本体泛化:共享潜在空间、技能扩展、分层技能库(p.74)

未来四大方向(第 9 章, p.78)

- 构建“机器人脑”:统一模型、持续学习、长时序鲁棒性

- 突破数据与 Sim2Real 瓶颈:高效数据飞轮、高保真可微分仿真

- 多模态物理交互:触觉/听觉融合、可变形物体建模

- 安全与协作:内在安全、多机器人协作、人机共享控制

简介

- 研究动机

- 机器人操作是具身智能的核心挑战之一,是一个基本而复杂的问题,需要无缝集成感知,规划和控制,以实现在多样化和非结构化环境中的交互

- Robot manipulation is a core and extensively studied task in embodied intelligence, defined as a robot’s ability to perceive, plan, and control its effectors to physically interact with and modify the environment, such as grasping, moving, or using objects.

- 贡献

- Extend the classical division between high-level planning and low-level control

扩展高级规划和低级控制之间的经典划分:扩展高级规划

- Language

- Code

- Motion

- Affordance

- 3D representations

- Introduce a new taxonomy of low-level learning-based control grounded in training paradigms such as input modeling, latent learning, and policy learning

根据训练范式分类基于学习的低级控制

- Input modeling

- Latent learning

- Policy learning

- Provide the first dedicated taxonomy of key bottlenecks, focusing on data collection, utilization, and generalization

关键瓶颈分类

- 大脑

- 数据

- 感知

- 安全

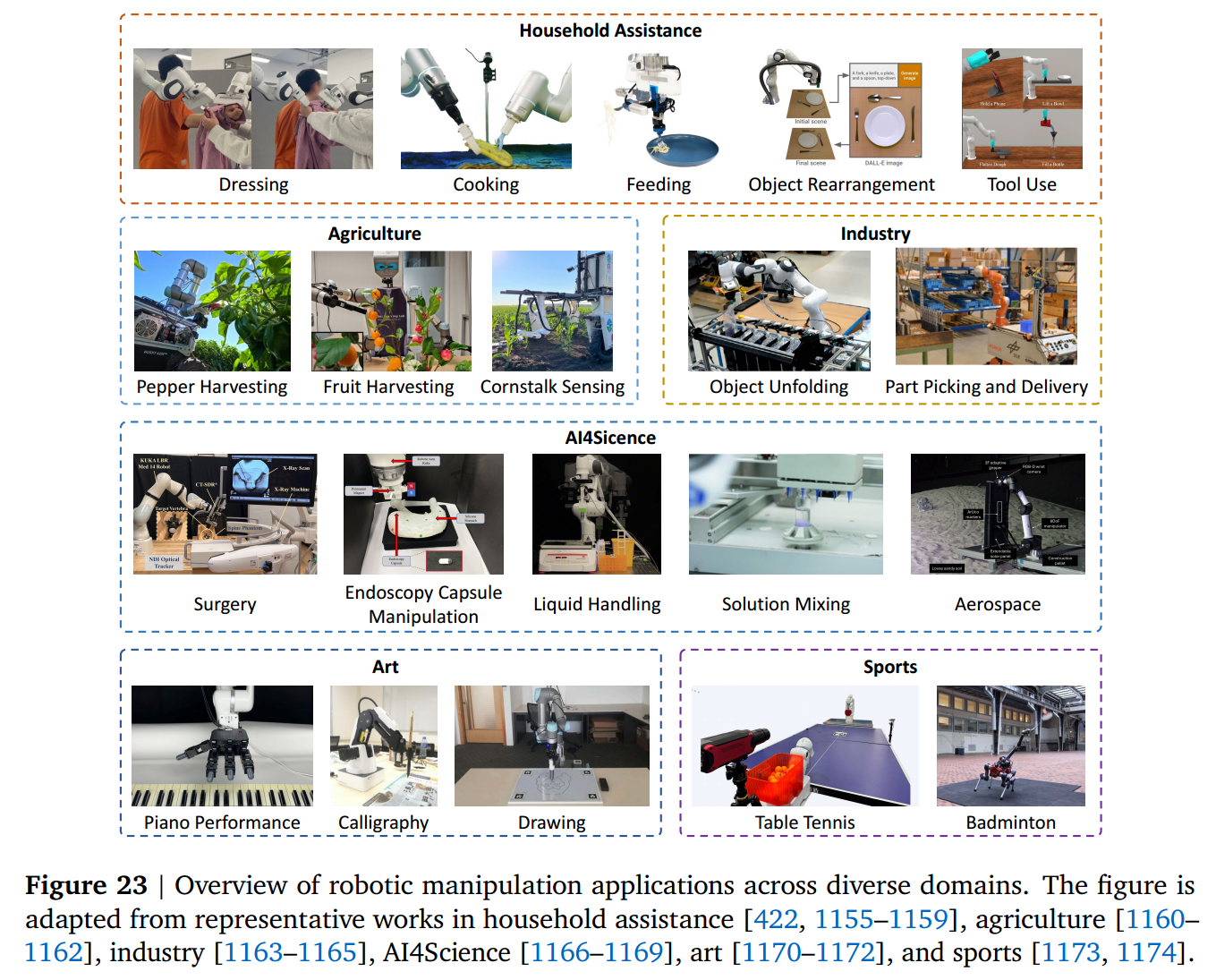

- Conclude with an extensive review of real-world applications 列举现实世界应用

- Extend the classical division between high-level planning and low-level control

扩展高级规划和低级控制之间的经典划分:扩展高级规划

- 理论派别和方法论

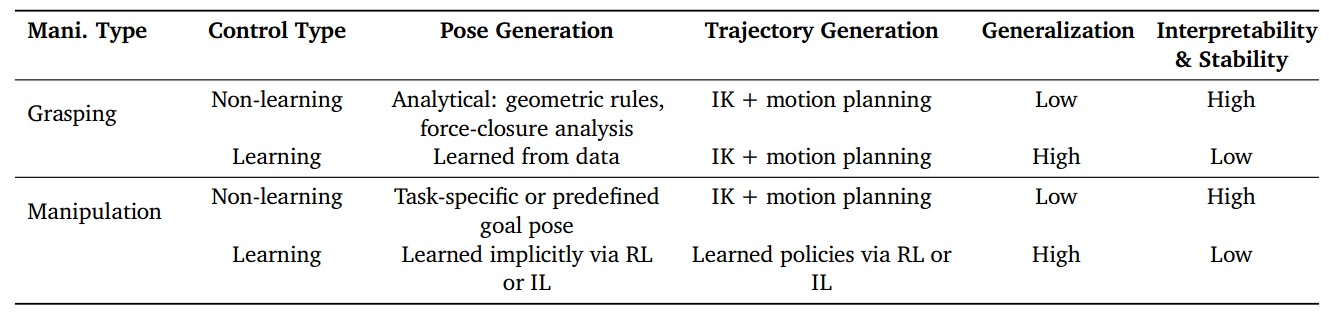

- Control Paradigms for Robotic Manipulation

- Rule-based and non-learning control methods

- Model Predictive Control (MPC) 利用预测模型预测未来状态并以滚动时域方式计算最优控制动作,能够实时重新优化能够适应干扰和动态环境,使 MPC 成为鲁棒和精确的机器人操作控制的流行选择

- Deep Learning-based approaches

- RL and IL

- RL

- Online:与环境交互

- Offline:收集数据集再训练

- Offline-to-Online

- IL

- 克隆 BC:sequential action mapping/generation problems 监督学习 策略将状态转为动作

- 反向强化学习 IRL:学习潜在奖励函数,然后再强化学习

- 生成对抗模仿学习(GAIL):distribution matching between the learner’s and the expert’s discounted occupancy measures

- RL

- & The integration of large language and vision-language models into IL and RL frameworks

- Rule-based and non-learning control methods

- Robotics Models

- Vision Models:为了感知环境,机器人模型通常结合视觉模型来提取信息性视觉特征。

- 纯视觉:ResNet/ViT/DINO

- 3D 感知:PointNet/PointTranformer

- Visual-language pretrained encoders:CLIP/SigLIP

- LLM:为了理解人类指令,利用文本理解和泛化能力

- BERT/GPT

- VLM:增强多模态理解和控制

- LLaVA/PaLM-E/Prism

- VLA:指使用机器人轨迹数据从基础 VLM 微调的模型,从更广泛的意义上说,任何接受视觉和语言输入并通过端到端管道输出机器人动作的模型都可以被认为是 VLA 模型

- RT-2

- Vision Models:为了感知环境,机器人模型通常结合视觉模型来提取信息性视觉特征。

- Evaluation

- 成功率 success rate/average success length

- 效率 task completion time/action frequency

- RL - 回报 return

- Control Paradigms for Robotic Manipulation

- 文章结构

- Hardware

- Bench marks and task categories

- Methods 按任务类型分类

- Grasp

- Basic manipulation

- High-level planners: task execution

- Low-level learning-based control strategies: precise actions

- Dexterous manipulation 灵巧

- Deformable manipulation 变形

- Mobile manipulation 移动

- Quadrupedal manipulation 四足

- Humanoid manipulation 人形

- Current bottlenecks

- 大脑:开发一个真正的通用架构,同时具有广泛的认知和控制能力

- 数据:解决数据瓶颈,验证 scaling-law

- 感知:更丰富的多模态传感和与可变形或其他复杂物体的可靠交互

- 安全:人机共存的安全性

- Practical applications

硬件平台

这些组件的不同组合定义了特定的实施例及其功能能力。例如,将平行钳口夹持器与弗兰卡熊猫臂配对,可以完成基本的操作任务,例如拾取和放置或插入,同时将 Unitree G1 人形平台与灵巧的手相结合,水平操作,需要更大的灵活性和协调性。

数据集与基准

任务

- Grasping(抓取)

- 稳定抓取 | 几何 → 深度学习 → VLM/LLM | 透明物体、泛化、姿态复杂

- 代表论文:DexNet;VL-Grasp;OWG

- Dexterous Manipulation(灵巧操作)

- 灵巧手控 | RL + IL + 视频模仿 | 接触建模、延迟、Sim-to-Real

- 代表论文:DexMV;DexGraspVLA;REBOOT

- Soft Robotic Manipulation(软体操作)

- 柔性控制 | 模型驱动 + 学习增强 | 欠驱动、材料差异、传感不足

- 代表论文:Soft DAgger;KineSoft

- Deformable Object Manipulation(可变形物体)

- 形变操作 | 点云建模 + 多模态学习 | 拓扑变化、形状重建、感知控制耦合

- 代表论文:DexDeform;DoughNet

- Mobile Manipulation(移动操作)

- 移动抓取 | 导航 + 控制 + VLA | 感知协调、动态障碍、长时序规划

- 代表论文:MoMa;Skill Transformer;MoManipVLA

- Quadrupedal Manipulation(四足操作)

- 走抓协同 | RL + MPC + 多模态 | 姿态协调、地形适应、时延稳定

- 代表论文:GAMMA;WildLMa;QUAR-VLA

- Humanoid Manipulation(人形操作)

- 全身操作 | RL/IL + VLA 对齐 | 平衡控制、协作、Sim-to-Real

- 代表论文:OmniH2O;Humanoid-VLA;GR00T N1

Basic Manipulation 流程

High-level Planner

Abstract

高层:决策能力的提升

- 目标:实现长期规划与开放环境应对(泛化)

- 方法:

- 逻辑推理 CoT

- 空间推理 scene graph integration

- 专用模型

- 故障处理

- 闭环反馈

- 多智能体协作/多机器人协作

- LLM-based Task Planning

- 与动作结合

- SayCan:技能成功概率与语言模型给出的任务相关性结合

- [361]:取消技能集,token-level joint decoding

- → Inner Monologue / LLM-Planner:闭环框架加入反馈,允许 LLM 在非结构化环境中动态调整计划

- 提高决策能力

- LLM+P:增强长期推理和规划能力

- REFLECT:故障感知,检查不成功的动作并纠正

- MALMM:多 LLM 协作,改善决策

- Polaris / Matcha:开放式任务交互

- RoCo:多机器人协同,以及多机器人操作任务的基准

- 与动作结合

- MLLM-based Task Planning 视觉信息由单独模型转换为文本输入 MLLM

- 模型设计(端到端决策,降低决策消耗)

- PaLM-E:在 curated embodiment dataset 上微调 VLM,与传统的视觉语言任务进行协同训练,存在大量数据需求和高计算需求

- VILA:直接使用 GPT-4V 而无需微调,利用基础知识就达到最先进的结果

- PG-InstructBLIP:在有物理概念注释的 object-centric dataset 上微调 InstructBLIP,更轻量,增强模型物理推理能力

- 提高决策能力

- EmbodiedGPT:引入 chain-of-thought (CoT) reasoning

- → [406]:引入 fine-grained reward-guided CoT

- SoFar / EmbodiedVSR:通过 scene graph integration 提高空间推理能力

- Socratic Models / Socratic Planner:多智能体协作,实现 zero-shot generalization

- AHA:故障处理,让 VLM 检测、解释故障

- RoboBrain / RoboBrain 2 / Gemini Robotics / RynnEC:在机器人数据集上训练的专用 MLLM,manipulation planning 优于通用 MLLM

- 模型设计(端到端决策,降低决策消耗)

- Code Generation 通过 LLM 和 MLLM 直接生成代码,灵活连接高级推理和低级执行

- 早期方法(实现更细粒度和更自适应的控制)

- Venkatesh:没有利用现代基础模型

- Code as Policies / ProgPrompt:引入感知和控制编程接口作为 prompts,直接生成可执行代码

- Vemprala:提出了一种可重用的工程管道,将 ChatGPT 集成到机器人系统中,以实现基于代码的在线控制

- 代码驱动的机器人操作策略

- Instruct2Act:增强视觉模态,改进多模态指令遵循和 zero-shot 泛化

- Demo2Code:将长期演示总结为可执行代码来扩展 CoT 框架

- SHOWTELL:将原始视觉演示直接转换为策略代码,不依赖于文本中间体

- Statler:通过维护显式世界状态来解决 LLM 的上下文长度限制

- HyCodePolicy:将符号日志与视觉语言模型的感知反馈集成在一起,增加闭环控制可靠性,适应动态环境

- 早期方法(实现更细粒度和更自适应的控制)

中层:物理能力的提升

- 目标:生成物理可行、空间可行、可解释的运动轨迹

- 方法:

- VLM 知识

- 几何 / 关键点约束

- 交互可行性图

- 结构化组合

- Motion Planning 利用 LLM 和 VLM 直接规划机器人运动轨迹

- VoxPoser:引入了基于 VLM 和 LLM 的 3D 值图,用作规划器的目标函数,生成平滑密集的末端运动轨迹

- CoPa / ManipLLM:利用 VLM 知识帮助规划器生成物理可行的运动轨迹

- ReKep:引入了关系关键点约束来增强运动规划的空间可行性

- GeoManip:利用几何约束来生成具有改进可解释性的运动轨迹

- Affordance as Planner 注明物体和环境能否与智能体交互,连接感知与动作

- Geometric Affordance

- 物体的功能可能性由其三维形状,结构和运动学决定

- → 直接从几何结构推断运动学模型,包括零件,关节和运动约束

- → 将复杂物体的功能解释为其功能部分的组合

- → 将复杂动作表示为对象部件之间几何约束的结构化组合

- Visual Affordance

- 直接从 2D 视觉数据(如 RGB 或 RGB-D 图像)中学习交互可能性

- 学习产生密集的像素级 affordance 表示图,指示可以在何处执行动作

- Semantic Affordance

- 研究高级符号概念和机器人动作之间的关系

- 通过将对象部件(如“手柄”或“盖子”)与特定的操作轨迹相关联,机器人能够将学习到的行为概括为具有相似语义属性的新对象

- Multimoadl Affordance 将交互演变为多模态对话

- 通过联合利用视觉外观,语言教学,空间背景和几何结构,超越了以上单一模式的方法

- → 将语言与视觉结合起来,把指令绑定到场景中

- → 显式 3D 空间推理,使模型能够捕获度量属性,如距离,方向和布局

- Geometric Affordance

- ? 3D Representation as Planner 通过产生结构化的行动建议来充当中级规划模块

- Gaussian-platting Scene Representations and Editing

- Implicit or Descriptor Fields

- Generative World Models:生成目标点云,并通过刚性配准将其转换为关键帧动作,有效地将动作推理作为本地生成任务

- Structured Scene Graphs:通过交互式探索逐步构建动作条件场景图,丰富状态与下游操作的动作相关关系

Low-level Learning-based Control

低层:将感知转化为可执行的动作

学习范式

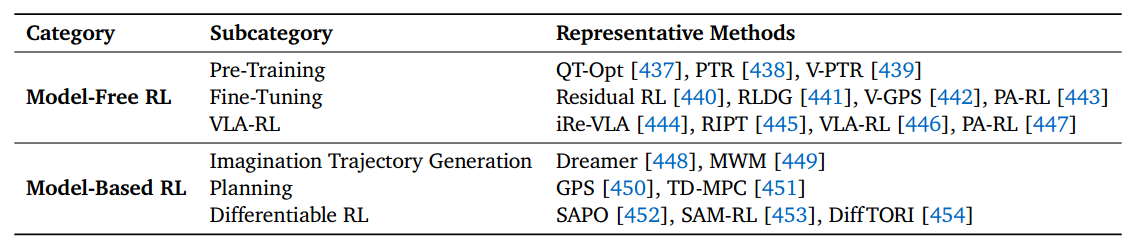

- RL

- Model-free:隐式动力学模型

- 策略:通过与环境的试错交互直接学习策略,由感知输入和奖励信号指导

- 优点:能够处理高维非线性任务,而无需精确的系统建模,非常适合复杂的操作场景

- 缺点:低样本效率和高数据要求

- 方法:

- 预训练:针对样本效率、可扩展性、泛化性做调优

- 策略:PTR

- 值函数:V-PTR

- 奖励函数:ReWiND

- 微调:

- 额外策略:Residual RL

- 策略蒸馏:RLDG,专家策略生成优质数据指导通用策略

- 重新排序:V-GPS / PA-RL;推理时用额外的网络在多个 action 中选择或调优

- & VLA:集中于为 VLA 设计高效的 RL 后训练方案(结合 IL)

重要的是如何让 VLA 不遗忘基础知识

- IRe-VLA:RL+IL 模仿专家数据,一边探索,一边防止“学歪”

- RIPT:舍弃 critic,直接估计优势函数,用少量示范就获得很大提升

- ConRFT:设计巧妙的损失函数,同时惩罚“与专家动作的不一致”和“与高回报策略的不一致”

- 预训练:针对样本效率、可扩展性、泛化性做调优

- Model-based:显式动力学模型(World Model)

- 策略:利用环境动态的显式或学习模型来促进策略学习 通过模拟轨迹学习动作

- 优点:实现更高的数据效率和更好的可解释性

- 缺点:性能受到动力学模型精度的限制,而动力学模型在高维或接触丰富的操作场景中很难获得——不适用于复杂操作场景

- 方法:Dreamer 系列

- Model-free:隐式动力学模型

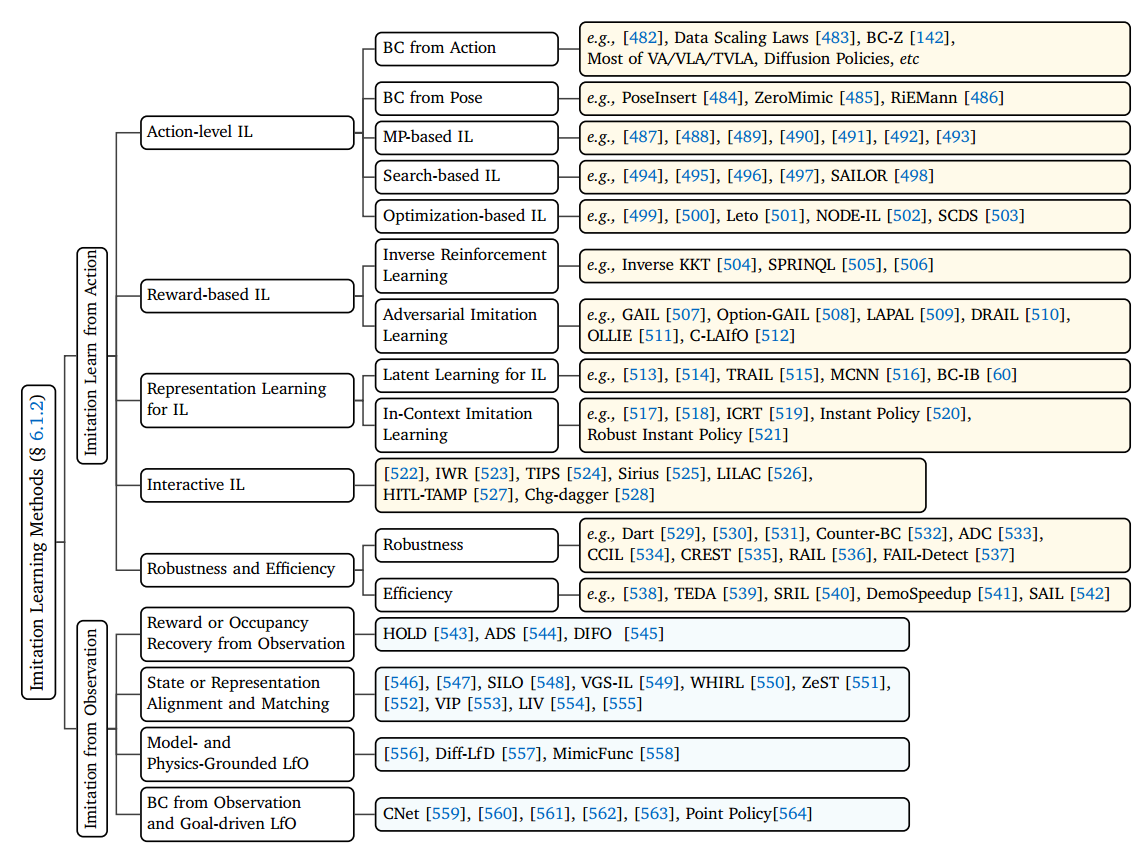

- IL

- 优点:与 RL 相比,IL 避免了昂贵的奖励设计和广泛的环境交互

- 方法:

- IL from Action:利用状态–动作对形式的专家演示(含传感器状态与对应控制命令)进行学习。

- Action-level IL:直接从动作/轨迹级演示学习策略,将状态映射为动作、位姿或运动原语,强调精准控制与稳定性。

- BC from Action:监督学习状态 → 低层动作。从回归发展到分层、多模态、结构先验、跨本体迁移;近期用高效 Transformer 实现多任务、小样本复用,并融合语言指令迈向通用操作。

- BC from Pose:预测 6D 末端位姿(SE (3)),交由底层控制器跟踪。几何感知提升精度与泛化。

- MP-based IL:用运动基元(DMP/ProMP 等)参数化技能,支持时序建模、约束融合与柔顺控制,向概率化、任务定制演进。

- Search-based IL:将模仿视为策略/轨迹搜索问题,结合 L2S 或 TAMP 规划器蒸馏分层策略,缓解协变量偏移,提升长时程性能。

- Optimization-based IL:以优化框架联合模仿目标与任务约束,发展出可微规划、Neural ODE、收缩动力学等方法,强调稳定与可靠。

- Reward-based IL:从演示反推奖励函数,再优化策略,提升泛化与可解释性。

- IRL:求解使专家轨迹最优的奖励(如 Inverse KKT、SPRINQL),理论统一为 f-散度最小化。

- AIL:通过对抗训练匹配轨迹分布(如 GAIL),改进包括鲁棒表征、偏好融合、离线预训练、潜动作空间等;无内层 RL 则仍属 IL 范畴。

- Representation Learning for IL:学习任务相关潜表征以提升策略泛化性与鲁棒性。

- Latent Learning for IL:提升潜变量的任务相关性(信息瓶颈、对抗约束、多意图、黎曼几何)、分布外泛化能力(信息论界、力/力矩信号)和时序稳定性(示范对齐、单视监督、记忆约束)。

- ICIL:推理时以少量演示为提示直接执行,通过图结构、序列建模和轨迹聚合实现免微调零样本泛化。

- Interactive IL:结合语言/遥操作、关键状态干预和运行时监控,实现低负担、安全的在线人机协同学习。

- Robustness and Efficiency

- Robustness:通过数据清洗、因果干预、安全滤波器和 OOD 检测,提升策略在噪声、扰动与分布偏移下的可靠性。

- Efficiency:借助模型压缩、演示重采样、动作调度与并行计算,加速训练与推理,支持实时部署。

- Action-level IL:直接从动作/轨迹级演示学习策略,将状态映射为动作、位姿或运动原语,强调精准控制与稳定性。

- Imitation from Observation (LfO):仅从专家状态/视觉轨迹(无动作标签)学习策略,通过隐式推理控制信号。

- Reward/Occupancy Recovery:从观测轨迹中恢复奖励、soft-Q 或占据测度(自动折扣调度、人视频奖励学习、扩散对抗、hindsight GAN),再用 RL 或规划优化策略,支持跨域与非对齐演示。 类似 Reward-based IL 但没有动作

- State/Representation Alignment:跨视角(比如第三人称与第一人称)/ 本体(比如人手与机械臂)对齐状态或潜表征(对偶离线 LfO、视觉-语言预训练、交互场模板、选择性/遍历匹配、图结构模仿、野外视频对齐),无需显式奖励。 在语义空间中对齐,更泛化

- Physics-Grounded LfO:结合可微仿真或动力学模型将视频投影为物理一致轨迹(可微物理 LfO、接触感知视觉模仿),提升接触任务的样本效率与可靠性。 物理一致性对齐,更可靠

- BC from Observation / Goal-driven LfO:从视频直接提取关键点、位姿或目标生成控制指令(关键点统一建模、眼在手人视频、零样本被动模仿、视觉运动生成元、目标推理控制),实现无动作监督的端到端执行。 类似 BC from Action 但没有动作

- IL from Action:利用状态–动作对形式的专家演示(含传感器状态与对应控制命令)进行学习。

- 未来方向:构建更通用、鲁棒、安全且易部署的机器人学习系统。

- 基础模型驱动 IL:为降低对大量演示的依赖,将 VLA/LLM 等基础模型融入策略,实现仅凭语言指令或少量示例的零/少样本任务泛化

- 因果模仿学习:为克服传统 IL 仅学统计相关性的局限,引入 do-calculus 与反事实推理,建模动作与结果的因果机制,提升分布外鲁棒性

- 跨任务与跨具身迁移:为实现“一次学习、多处复用”,发展形态无关或任务组合的策略表示,支持策略在不同机器人或新任务上的快速迁移

- 安全部署:为保障医疗、家庭等高风险场景的可靠性,通过形式化验证、运行时监控与不确定性量化,确保策略在异常或分布偏移下仍安全可控

- 高效人机交互:为减少高昂的人类演示成本,探索用语言、偏好、粗略轨迹等弱监督信号,结合主动学习与自监督,实现低负担策略学习

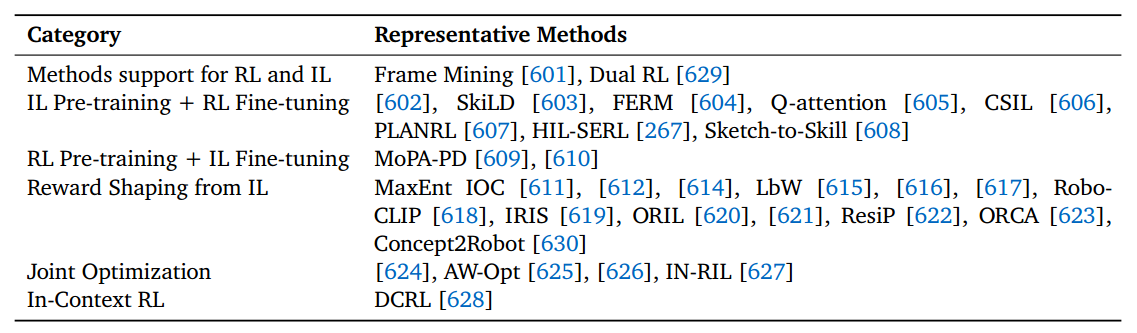

- RL+IL

- 统一框架:共享优化基底,灵活切换监督源

- 预训练+微调:IL→RL(快速启动、超专家性能)或 RL→IL(通用技能对齐具体任务)

- 奖励/目标塑造:从演示/视频提取奖励(逆最优控制、偏好学习)、感知目标(表征匹配、目标接近度)或隐式价值

- 联合优化:将模仿损失作为 RL 正则项或交替训练,提升样本效率与稳定性

- 上下文 RL:将演示作为上下文输入,纯回报优化实现少样本泛化,无需显式模仿损失

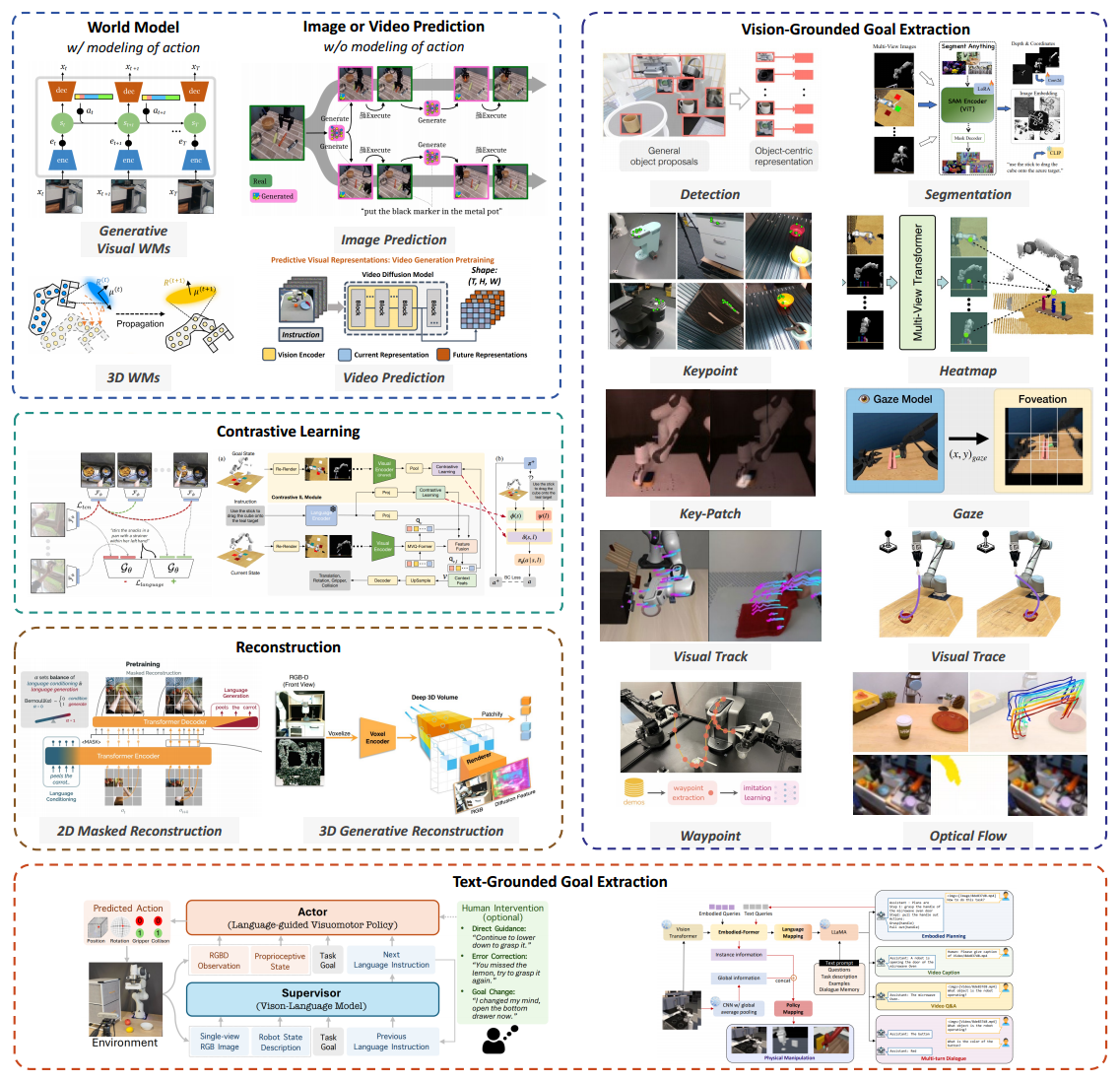

- Learning with Auxiliary Tasks

- World Model 减少对昂贵的现实世界交互的依赖

- Generative Visual WMs

- 思想:将视频生成器视为“可交互环境”,在像素或潜空间展开 rollout,产生额外训练数据

- 趋势:从通用视频扩散 → 机器人轨迹微调 → 带语言约束的闭环 MPC(VLMPC)

- 3D or Physics-consistent WMs

- 思想:用高斯散斑/粒子/流体重建可导物理层,保证几何与动力学一致

- 趋势:单任务高斯 → 多任务分层高斯++ → 跨物体、跨材料统一表示

- Policy Learning with WMs

- 思想:世界模型直接提供 latent MPC 接口或奖励信号,而不再仅“生成数据”

- 趋势:离线预训练+在线微调 → 与扩散策略联合优化 → 残差-规划两阶段架构

- System-level & Fleet-scale WMs

- 思想:多机共享统一世界模型,实现分布式协同与持续更新

- 趋势:单机模型 → 云端统一平台(Cosmos/Genie Envisioner)→ 实时协同更新

- Generative Visual WMs

- Image or Video Prediction

- 思想:直接合成未来视觉信号或目标图像,作为视觉规划器或数据增强引擎。

- 趋势:从单目标帧 → 可控视频规划 → 跨域人类视频迁移与隐式动力学挖掘。

- Vision-Grounded Goal Extraction 直接从视觉输入中获取任务相关信息以支持操作任务

- Detection / Segmentation

- 思想:2D/3D 框或掩码直接当目标

- 趋势:开放词汇检测 → SAM-like 提示分割 → 跨帧实例关联

- Gaze & Foveation

- 思想:用人眼注视或预测注视裁剪视野

- 趋势:注视点 → 主动视角控制 → 与 Transformer 注意力融合

- Key-point / Key-patch / Key-pose

- 思想:稀疏几何锚点表示任务

- 趋势:语义-运动混合关键点 → 双手机 keypose → 层次 keypose-轨迹

- Waypoint / Visual Trace / Flow

- 思想:稀疏/稠密运动轨迹作为目标

- 趋势:2D 轨迹 → 3D 场景流 → 对象级光流奖励塑形

- Detection / Segmentation

- Text-Grounded Goal Extraction

- 思想:将自然语言指令解析为结构化目标、推理链或恢复信号,实现语义到动作对齐

- 趋势:从单步指令 → 链式思维 → 失败恢复与对象级语义增强

- Contrastive Learning

- 思想:通过正负样本对比,学习跨模态、跨任务、跨视角的共享表征

- 趋势:从通用视觉预训练 → 语言-动作对齐 → 轨迹级对比与语言偏好对比

- Reconstruction

- 2D Masked Reconstruction

- 思想:随机掩码 RGB/深度图自监督

- 趋势:帧级 → 时空 tube → 多模态掩码(RGB+触觉+proprio)

- 3D Masked / Generative Reconstruction

- 思想:多视角 NeRF/特征场补全

- 趋势:单物体 → 多物体 → 动态场景 → 可编辑高斯散斑

- 2D Masked Reconstruction

- World Model 减少对昂贵的现实世界交互的依赖

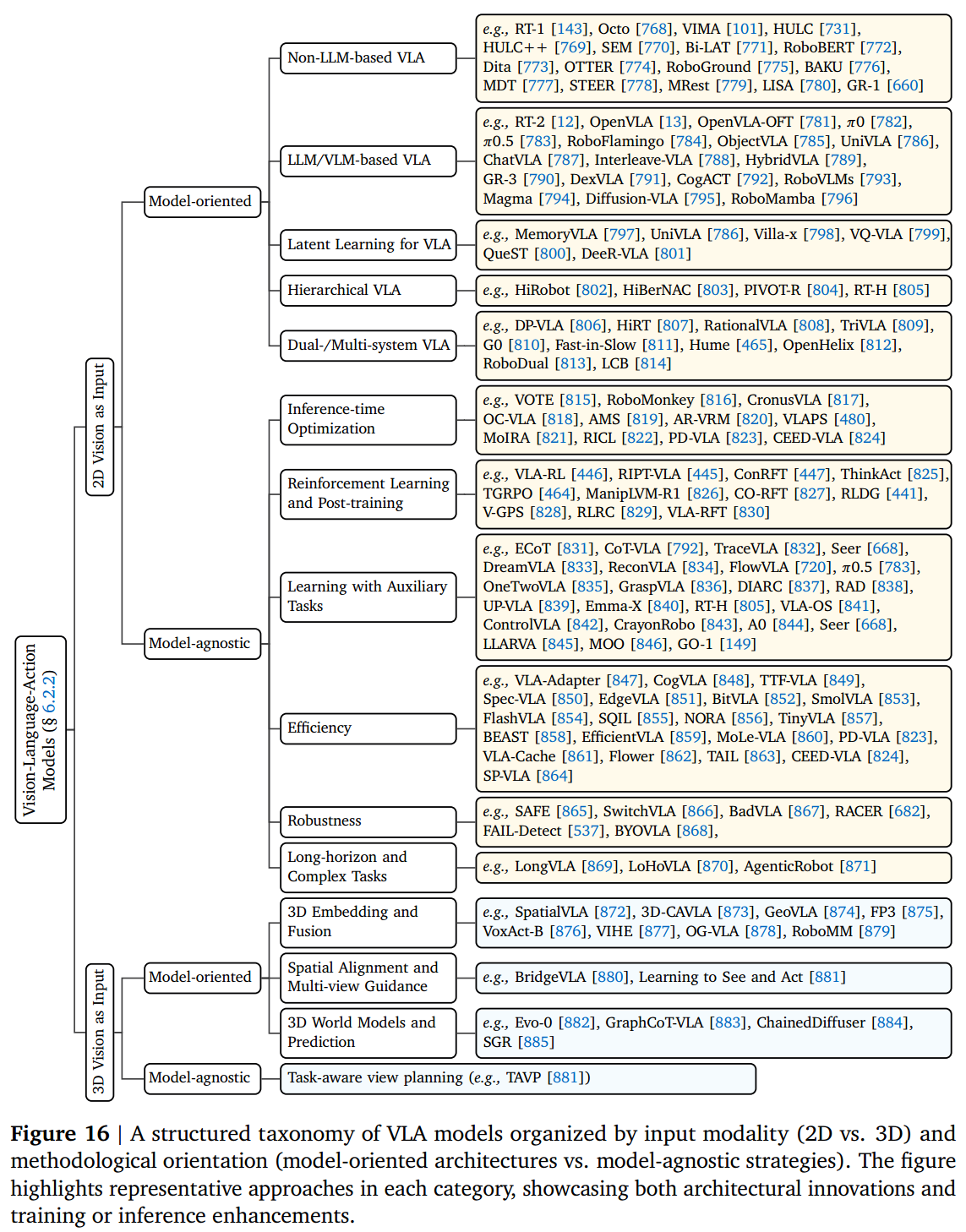

输入建模

- VAM

- 2D Vision as Input

- 思想:以单目/多目 RGB 图像为唯一视觉输入,用 CNN/Transformer/扩散模型直接映射到动作。

- 趋势:从 ResNet 卷积 → 纯 Transformer → 扩散策略;逐步引入多视角时序融合,但仍缺乏 3D 与语义 grounding。

- 3D Vision as Input

- 思想:显式引入点云、深度或体素,提供度量几何信息以提升接触与遮挡鲁棒性。

- 趋势:点云 Transformer → 多视角统一投影 → 与扩散/流匹配策略端到端联合训练;下一步与语言-语义模型深度耦合。

- 2D Vision as Input

- VLA 将语义基础、空间推理和顺序动作生成集成在单个体系结构中

- 共性趋势(2D & 3D)

- Model-oriented:引入 LLM/VLM 先验、潜层结构、分层推理(2D);利用 3D 嵌入、对齐机制、世界模型(3D)→ 统一增强表征容量。

- Model-agnostic:少重训、重推理,聚焦鲁棒与效率提升。

- 未来关键方向

- 3D 表示标准化:统一点云/体素/高斯接口,降低跨模型迁移成本。

- 混合安全双系统:反应式控制 + 审议式规划,内置安全约束,实现长时程稳健执行。

- 2D-3D 协同训练:联合大规模语义先验与度量几何,兼顾语言泛化与空间精度。

- 一体化架构:感知-记忆-规划-控制全栈耦合,面向长视野、跨 embodiment、真实部署评估。

- 共性趋势(2D & 3D)

| 类别 | 子方向 | 核心优点 | 主要缺点 |

|---|---|---|---|

| 2D mo | Non-LLM-based VLA | 结构轻量,端到端易训练;动作离散化后直接 Transformer 输出 | 缺乏大语义先验,跨域/复杂指令泛化弱 |

| 2D mo | LLM/VLM-based VLA | 继承 Web 级语义,零样本跨物体任务强;可链式思维推理 | 模型大、延迟高;需大量机器人数据微调,否则易“幻觉”动作 |

| 2D mo | Latent Learning for VLA | 量化/连续隐动作压缩空间,样本效率高;易跨 embodiment 共享 | 隐空间可解释性差;码本塌陷或连续漂移导致控制不稳 |

| 2D mo | Hierarchical VLA | 高层子目标+底层原语,长时程误差小;模块化易调试 | 子目标定义依赖手工或额外模型;高层错误会级联到底层 |

| 2D mo | Dual-/Multi-system VLA | 快慢系统分工,兼顾实时与深度推理;可插拔安全通道 | 仲裁机制复杂;多阶段对齐训练,内存一致性难维护 |

| 2D ma | Inference-time Optimization | 无需重训即可提升鲁棒性(投票/校准/重排序);即插即用 | 多次前向增加延迟;效果受基础策略质量上限限制 |

| 2D ma | Reinforcement Learning & Post-training | 在线交互持续改进,可超越演示;适配具体硬件动力学 | 探索成本高;超参敏感,易过拟合局部环境 |

| 2D ma | Learning with Auxiliary Tasks | 自监督重建/预测增强表征,减少标注依赖 | 辅助损失权重难调;任务冲突可能稀释主策略信号 |

| 2D ma | Efficiency | 量化/剪枝/缓存显著降低 FLOPs 与内存,边缘端可部署 | 压缩后精度-延迟权衡陡峭;需重新校准动作分布 |

| 2D ma | Robustness | OOD 检测、安全约束、对抗训练提升现场安全性 | 鲁棒模块常需额外传感器或先验;极端场景仍可能失效 |

| 2D ma | Long-horizon Generalization | 记忆/图结构/递归支持多步推理,任务完成度更高 | 训练序列长,梯度消失风险大;对内存与计算需求倍增 |

| 3D mo | 3D Embedding & Fusion | 点云/体素提供度量几何,显著提升遮挡、透明物体表现 | 3D 编码器参数量大;仿真-真实点云分布差异导致迁移 gap |

| 3D mo | Spatial Alignment & Multi-view Guidance | 跨视角一致性减少姿态歧义,提升抓取精度 | 依赖精确相机标定;视角规划模块增加在线计算链 |

| 3D mo | 3D World Models & Prediction | 潜空间 rollout 未来 3D 状态,支持长时序物理一致规划 | 复杂场景预测误差随步数指数放大;需与策略交替优化,训练不稳定 |

| 3D ma | 任务感知的视角规划 & 动作可行性检查 | 无需重训,即插即用;对空间定位精度有直观提升 | 探索极少,缺系统方案:校准、共识解码、缓存、轻量推理等仍未成形;视角规划模块增加在线计算链,延迟与误差累积问题待解决。 |

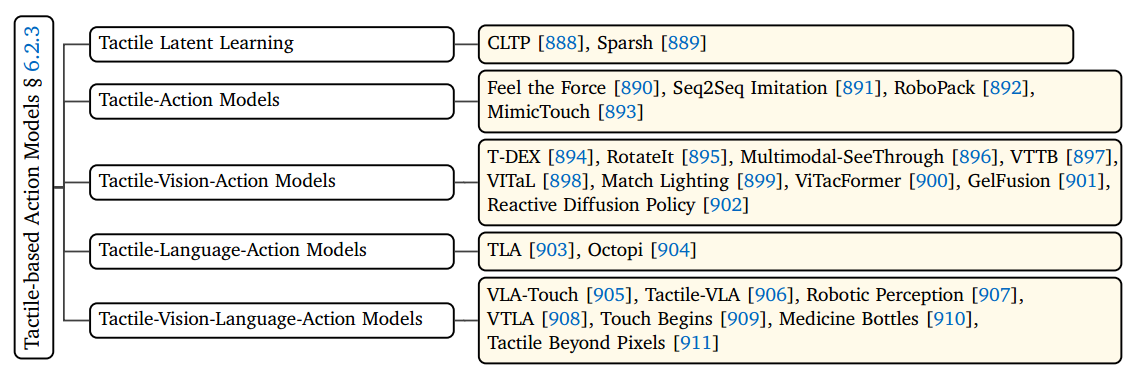

- 额外模态

- 触觉

- 力:ForceVLA

- 音频:VLAS

- 触觉

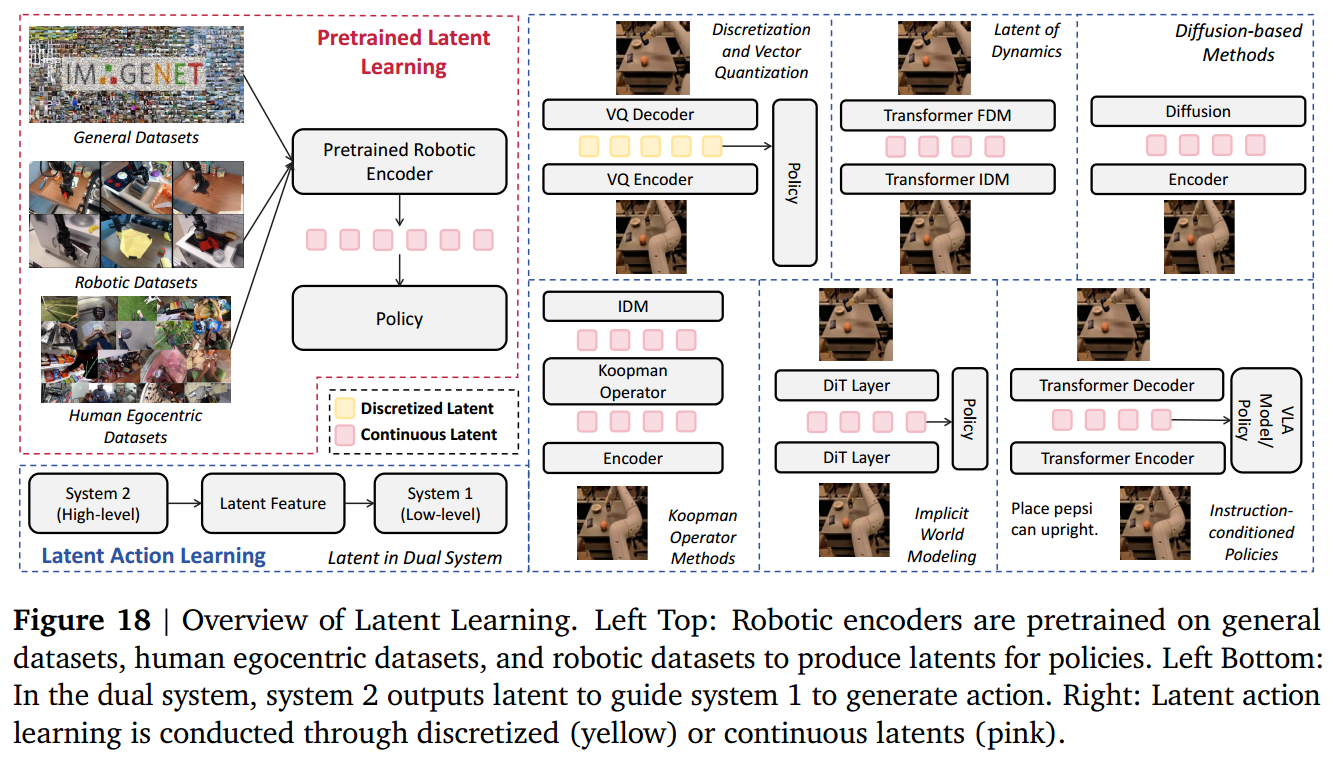

潜在学习

- Pretrained Latent Learning

- 思想:在大规模人眼视频或机器人数据上做自监督/多模态预训练,输出通用视觉/多模态编码器。

- 优点:即插即用,跨任务、跨 embodiment 无需重新训练编码器。

- 缺点:预训练数据域与下游控制域仍存在差异,需额外微调或适配层。

- 分类:

- 通用数据集,如 ImageNet

- Human egocentric dataset,如 Ego4D 较为常见

- 机器人数据集,如 BridgeV2

- Latent Action Learning

- 思想:将动作空间也纳入潜空间,联合优化“潜表征→动作”的时序或因果映射(离散 token、连续动力学、隐式世界模型)。

- 优点:潜变量直接成为规划与控制的内部接口,压缩动作维度、降低复合误差。

- 缺点:潜空间可解释性差,存在码本塌陷或连续漂移风险;训练需联合策略网络,超参敏感。

- 分类:

- 离散表示:将连续的动作或表示空间映射到离散令牌的有限集合中,从而提供简化策略学习的紧凑、可重用的动作原语

- 连续表示:将动作编码为连续空间中的向量,允许机器人捕获运动中的细粒度变化,并实现跨行为的平滑插值和泛化 较为常见

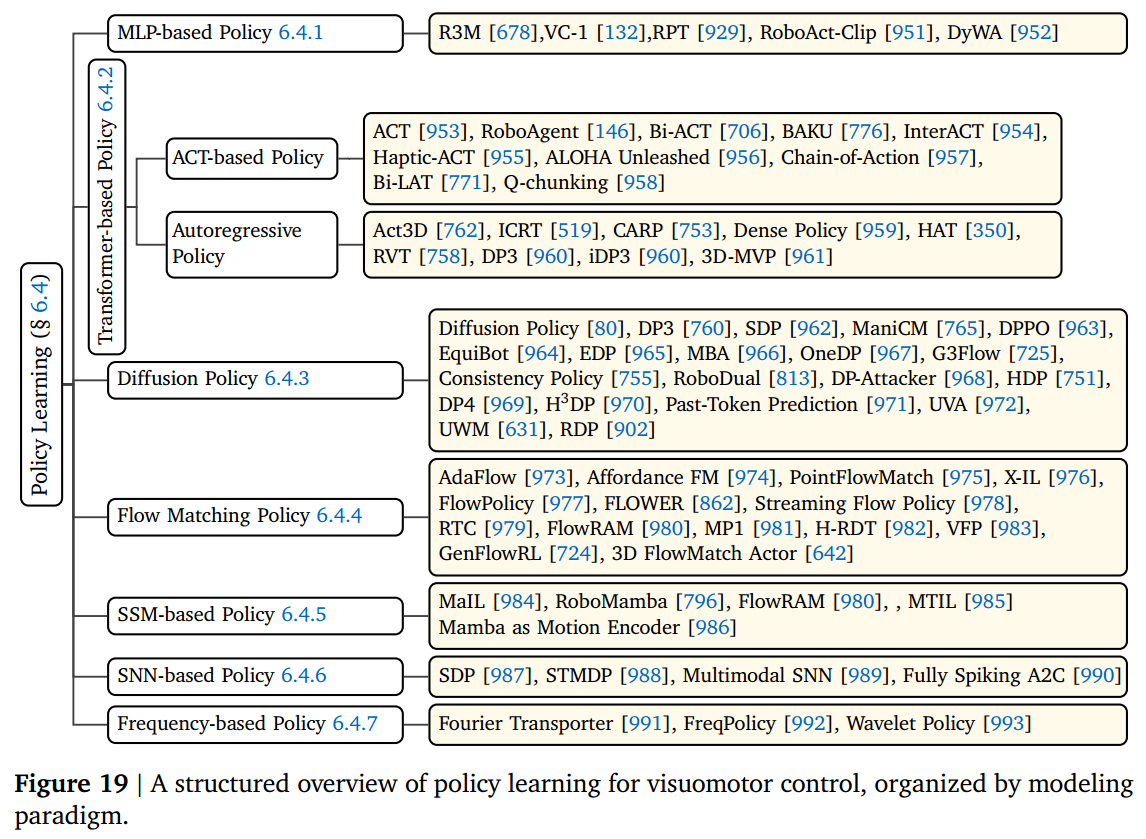

策略学习

| 子方向 | 定义 | 优点 | 缺点 |

|---|---|---|---|

| MLP-based Policy | 多层感知机直接将观测向量映射为动作 | 结构简单、训练快、易部署 | 表征能力有限,长时序与多模态融合差 |

| Transformer-based Policy | 用自注意力/交叉注意力处理时序观测与语言目标,输出动作序列 | 感受野长,易融合多模态与历史;支持可变长度上下文 | 计算量随序列长度二次增长;对硬件内存要求高 |

| Diffusion Policy | 把动作生成视为条件去噪扩散过程,迭代恢复动作轨迹 | 可采样多模态分布,抗复合误差;对演示噪声鲁棒 | 推理需多步去噪,延迟大;对超参与调度敏感 |

| Flow Matching Policy | 直接学习噪声→动作的可逆映射(常微分方程),单步或少量步生成轨迹 | 训练稳定、推理快;轨迹平滑连续 | 需设计合适的向量场结构;极端多模态场景表达能力不如扩散 |

| SSM-based Policy (Mamba 等) | 用线性状态空间层替代注意力,线性复杂度建模长序列 | 长序列建模高效,推理内存恒定;可并行训练 | 结构新,工程实现与调参经验少;对超参敏感 |

| SNN-based Policy | 脉冲神经网络以离散脉冲编码,事件驱动更新 | 超低功耗,硬件友好;具备生物可解释性 | 训练算法复杂(基于脉冲时序可塑性);精度通常低于传统网络 |

| Frequency-based Policy | 在傅里叶/小波域表示动作轨迹,用频谱一致性约束或预测系数 | 天然平滑,易嵌入长期周期/节律先验;参数少 | 依赖轨迹 Stationarity 假设;瞬态与高频突变动作建模不足 |

| 其中 Diffusion Policy 和 Flow Matching Policy 较为常见 |

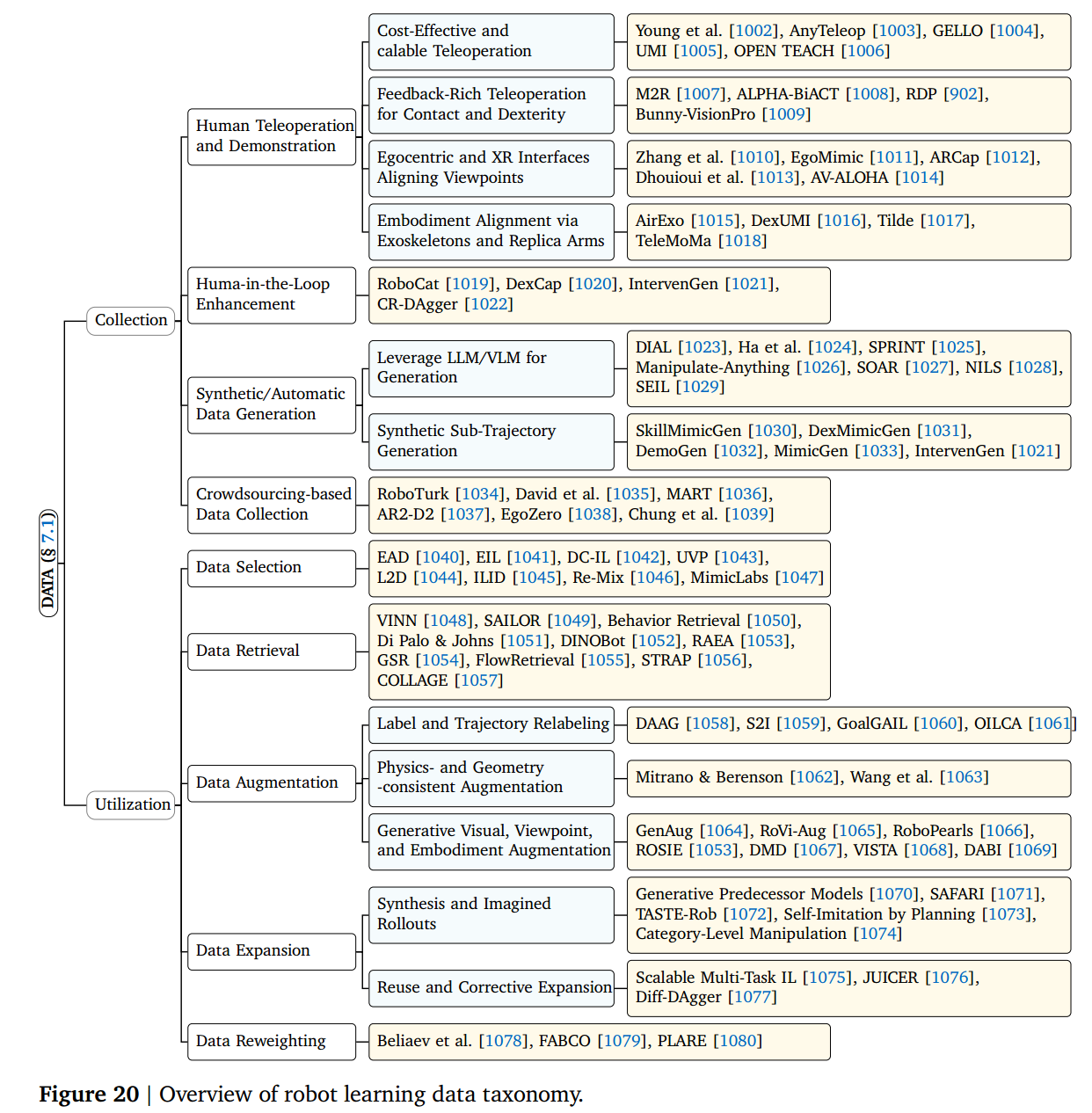

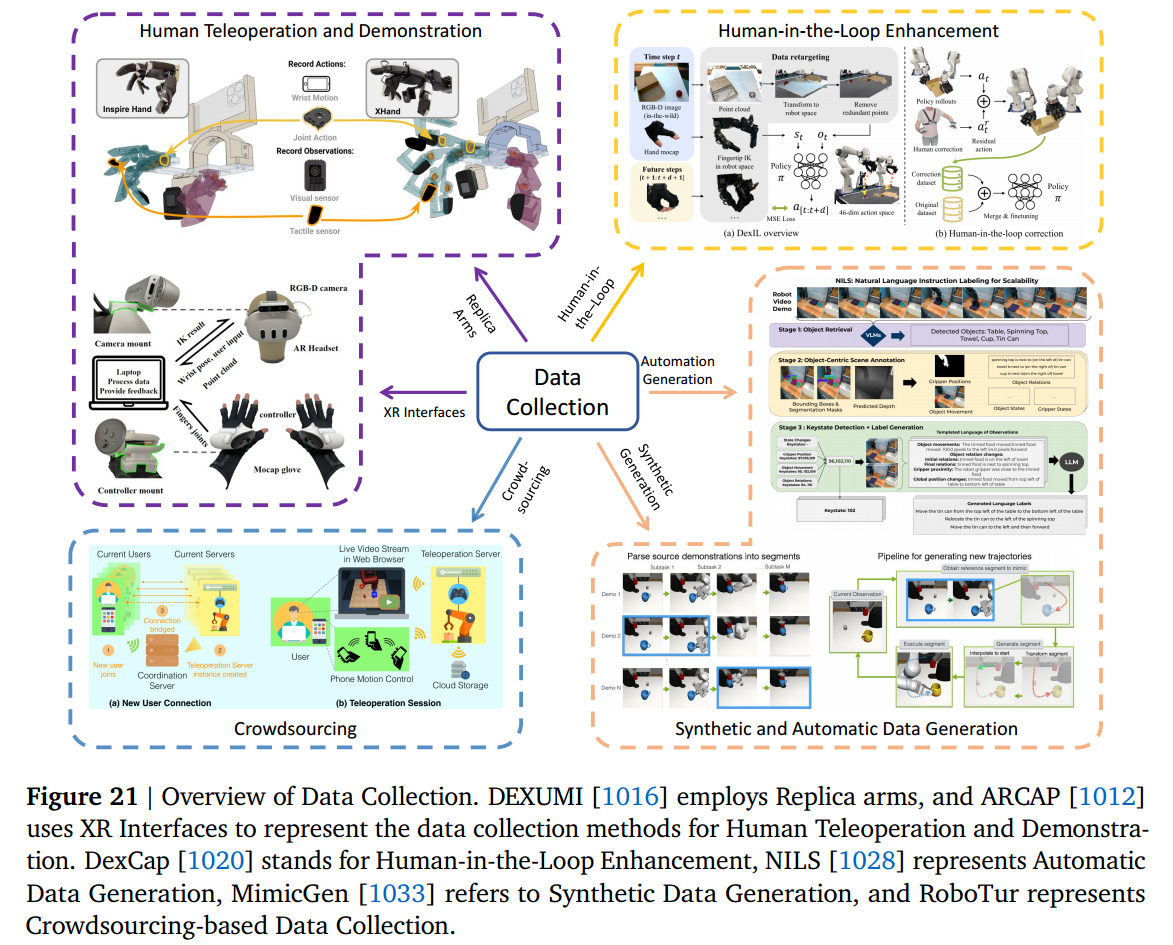

关键瓶颈突破

- 数据

- 泛化

- 环境

- 任务

- 机器人

| 大方向 | 子方向 | 在做什么? | 要解决的问题 |

|---|---|---|---|

| 7.1 数据 | 人类遥操作/示教 | 用低成本手柄、XR、外骨骼等采集高质量演示 | 降低数据采集门槛,扩大规模与多样性 |

| 人在回路增强 | 局部修正、干预、重打分,迭代提升数据质量 | 自动过滤失败轨迹,减少无效探索 | |

| 合成/自动生成 | LLM+VLM 分解任务→规划→仿真回放;或子轨迹变异 | 用零样本或少量真机 rollout 生成大量新演示 | |

| 众包数据crowdsourcing | 云平台+手机/AR 让非专家远程操作 | 打破“专家+设备”瓶颈,快速累积跨域数据 | |

| 数据选择 | 基于嵌入、偏好、可行性给样本加权/去噪 | 清洗低质量、冲突或冗余演示,提升训练信号信噪比 | |

| 数据检索 | 按任务嵌入从大数据库召回相似片段再回放 | 少样本场景下快速复用历史经验,降低采样复杂度 | |

| 数据增广 | 物理一致变换、生成式场景编辑、目标重标记 | 扩大视觉/几何/ embodiment 分布,缓解过拟合 | |

| 数据扩展 | 用世界模型或 planner 想象新轨迹;轨迹重组 | 不新增真机数据即可指数级增加有效样本 | |

| 数据重加权 | 按专家度、可行性、偏好给样本不同权重 | 抑制噪声演示影响,强化高价值轨迹监督信号 | |

| 7.2 泛化 | Sim-to-Real & Real2Sim2Real | 随机化、域适配、数字孪生重建 | 弥合仿真-真实动力学/感知差距,实现零-shot 部署 |

| SE (3)/SIM (3) 等变 | 网络结构强制姿态/尺度协变 | 减少视角、物体姿态变化带来的性能下降 | |

| 光照/背景/干扰 | 增广、因子化表征、基础模型先验 | 克服实验室固定光照与干净背景过拟合 | |

| 长时程任务 | 技能链、语义分解、结构表征 | 解决多步序错误累积与稀疏奖励问题 | |

| 组合泛化 | 数据/程序/模块化策略重组已知技能 | 让机器人用“积木”方式解决未见任务组合 | |

| Few-shot / Meta Learning | 嵌入先验、任务条件式微调、快速适应 | 仅几条演示即可掌握新物体/新规则 | |

| 终身/增量学习 | 模块化、提示池、回放机制 | 避免灾难遗忘,持续累积技能库 | |

| 跨 Embodiment | 共享潜空间、统一技能库、注意力模块化 | 同一策略驱动不同形态机器人,降低单机型开发成本 |

应用

未来研究方向

| 核心挑战 | 要解决什么 | 关键技术/趋势 |

|---|---|---|

| 9.1 构建真正的“机器人大脑” | 打破“一机一模型”,实现单一通用模型跨 embodiment、跨任务、持续学习且长时程稳健 | - 通用架构:统一观测/动作空间、模块化网络 - 持续 & 终身学习:动态扩展、记忆回放、正向迁移 - 长时程鲁棒:因果推理+闭环反馈,维持“成功漏斗” - 平滑运动生成:嵌入阻抗/变导纳控制,确保人机安全 |

| 9.2 数据瓶颈 & Sim-to-Real 鸿沟 | 低成本获得“海量、高信噪比”真机数据;仿真到真实迁移可靠 | - 数据飞轮:模型自驱探索 → 自动标注/过滤 → 迭代训练 - 真机数据标准化:格式、质量评估、自动去噪 - 高保真可微仿真:把物理引擎(接触、摩擦、形变等)写成可导算子,能反向传播梯度;策略损失可直接回传到控制器参数 |

| 9.3 多模态深度物理交互 | 突破“纯视觉”上限,实现类人多模态感知与复杂物体操作 | - 全模态传感:视-听-触-本体-温度-气体电子皮肤 - 跨模态对齐:异步、多速率信号统一嵌入空间 - 可变形/流体建模:GNN+可微物理,拓扑变化在线推理 |

| 9.4 安全与协作 | 人机共存、多机协同、故障自愈,达到“内在安全+自然交互” | - 内嵌安全:实时力-能量-速度约束;自监控与故障恢复 - 机机协同:共享安全协议+预测式冲突消解 - 自然 HRI: gaze-语音-姿态融合推断意图;共享自主 - 混合范式:Learning + 经典控制/规则,确保高可靠场景零事故 |